インターネット上のコンテンツが増えるにつれて、コンテンツモデレーション(投稿監視)の重要性が高まっています。

口コミサイトなどUGC(ユーザー生成コンテンツ)やSNSをはじめとして、オンライン上の悪意ある不適切コンテンツの監視は企業にとって、自社のブランドイメージや価値を守るために必要な手段です。

なぜ企業がコンテンツモデレーション(投稿監視)を行うべきなのか、その方法や手段などを包括的に解説していきます。

人事に関するお役立ち情報をお送りいたします。

メールマガジン登録

コンテンツモデレーション(投稿監視)とは

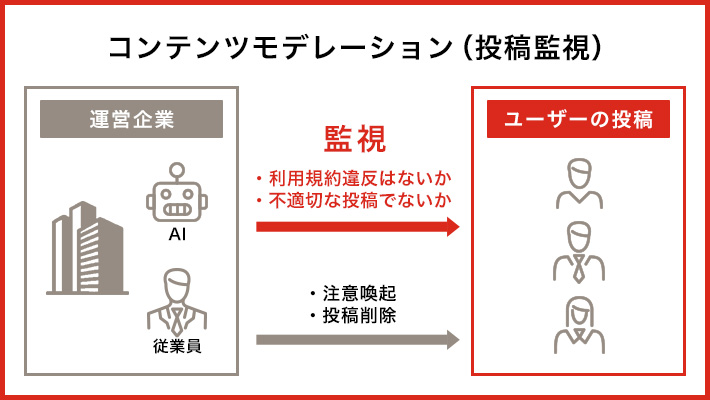

コンテンツモデレーション(投稿監視)は、インターネット上におけるコミュニティ(SNSなど)やプラットフォーム上(口コミサイトなど)において投稿されるコンテンツを監視・管理し、不適切な内容をモニタリングする取り組みです。

情報を意味する「コンテンツ」という言葉と、適切にするという意味の「モデレーション」を合わせた言葉です。

SNS上におけるヘイトスピーチや暴力的な画像、オンラインゲーム内でのいじめ行為、口コミサイト上での悪意ある投稿などに代表される、不適切投稿がモデレーションの対象となります。

コンテンツモデレーション(投稿監視)を行うことにより、ユーザー体験を最適化するとともに、プラットフォームの信頼性を担保し、健全なオンラインコミュニティを構築できるなどの効果が期待できます。

コンテンツモデレーション(投稿監視)が注目される背景

コンテンツモデレーション(投稿監視)が注目される背景にはどのようなものがあるのでしょうか。

①スマホの普及とSNSの急速な成長

スマホやタブレットなどに代表される個人向けデバイスの急速な普及により、場所を問わずオンライン上のコンテンツに触れる機会が増えました。

またソーシャルメディアが急速に成長したことにより、監視対象のコンテンツ数も飛躍的に伸びています。

こうした状況を悪用しようとSNSを介してフェイクニュースを流すケースや、子供がインターネットやSNS経由で犯罪に巻き込まれるケースも増加しています。

日本政府も「総務省 プラットフォームサービスに関する研究会:誹謗中傷等の違法・有害情報への対策に関するワーキングループ」を組み、研究を進めています。同グループでは情報量が膨大になっている昨今において、自動化ツールは不可欠であるとしています。

参考・出典:参考・出典:プラットフォームサービスに関する研究会第二次とりまとめ(案) │総務省

参考・出典:あなたのお子さんは大丈夫?スマホ、携帯にご注意を!ネット犯罪の落とし穴│政府広報オンライン

参考・出展:総務省プラットフォームサービスに関する研究会: 誹謗中傷等の違法・有害情報への対策に関するワー キンググループ(第5回)

②プラットフォームの信頼性確保の重要性

企業にとってプラットフォームの信頼性を確保することは、運営上きわめて需要です。

悪意のあるコンテンツは安全なコミュニティ形成を阻害してユーザーの満足度を下げるだけでなく、犯罪などに繋がってしまう場合もあります。結果として、企業などのブランドイメージを損なってしまう可能性があります。

プラットフォームの信頼性は新規ユーザー獲得や、既存ユーザーの継続的利用にも深く関わります。

ユーザーの安全性とプラットフォームの信頼性確保、企業のブランドマネジメントの観点から、コンテンツモデレーション(投稿監視)に注目が集まっています。

コンテンツモデレーション(投稿監視)の目的

コンテンツモデレーション(投稿監視)の目的を見ていきましょう。

①不適切なコンテンツの拡散防止

悪意のある不適切なコンテンツの拡散は、健全な目的で利用しているユーザーを混乱させ、企業のブランド価値を棄損しかねません。

また、不適切なコンテンツには暴力や犯罪行為を含むなど違法な要素を含んでいる場合もあり、このような場合には特に拡散防止と削除を徹底する必要があります。

②安全で快適なプラットフォーム運営

コンテンツモデレーション(投稿監視)は、ユーザーにとって安全かつ快適なプラットフォーム運営にとって欠かせない要素です。

不適切なコンテンツを取り締まることで、ユーザーが安心して参加できるようになり、プラットフォームにおける快適なコミュニティ形成を促進します。

③ブランドマネジメント

コンテンツモデレーション(投稿監視)はブランドマネジメントにも影響を及ぼします。

安全で快適なプラットフォーム運営を担保し、外部のSNSやコミュニティでの不適切なコンテンツを監視・排除することで、企業のブランドイメージの維持とロイヤリティの維持・向上が期待できます。

ビジネスを拡大する際には、コンテンツモデレーション(投稿監視)が欠かせないといえるでしょう。

コンテンツモデレーション(投稿監視)の方法と種類

コンテンツモデレーション(投稿監視)には以下の方法があります。

|

精度

|

モデレーターへの負荷

|

|

|---|---|---|

| AIやツールによる自動フィルタリング | △ | 低 |

| 手動によるチェック | 〇 | 高 |

| ユーザー相互のコミュニティ監視 | 〇 | 低 |

| 手動とAIの組み合わせ | ◎ | 中 |

①AIやツールによる自動フィルタリング

AIやツールによる自動フィルタリングは、事前に定義されたルールやアルゴリズムに基づいてコンテンツをフィルタリングしていきます。AIフィルタリングでは、著作権侵害の検出やスパム・不正行為の検出が可能です。

より細かい特定の文言を指定したテキスト検出や画像内のオブジェクト検出も可能で、適切な広告表示などにも活用できます。

ただし、アルゴリズムから漏れてしまうリスクもゼロではありません。

②手動によるチェック

モデレーターがコンテンツを手動でレビューし、ガイドラインに適合しているかどうかを判断します。

例えば、大量に同様の投稿がされている場合や違法コンテンツ、著作権違反やスパムと思われるコンテンツ、政治的なコンテンツなどを見て、その都度自社におけるガイドラインに適しているか見ていきます。

目視でチェックを行うため、精度は高くなります。ただし、モデレーターの負荷が高く、また個人の力量に依存するというデメリットもあります。

③ユーザー相互のコミュニティ監視

ユーザーが不適切なコンテンツを報告する仕組みによって、メンバーが共同で安全性を確保する方法です。

例えばGoogleではポリシーに違反する虚偽の投稿や、悪意のあるコンテンツのアップロードが見られるユーザーを不適切として報告できます。

ただし、ユーザーが必ず報告する保証はないため、他の手法と組み合わせて使用されることが多く、補完的な手法と言えます。

④手動とAIの組み合わせ

AIによるフィルタリングと、人間のモデレーターによる手動レビューを組み合わせる方法も一般的です。

例えば事前に設定したキーワードで自動フィルタリングをかけます。その後で人の手によるレビューを行って、実際にガイドラインに違反する形でキーワードが使われているか確認をします。

文脈によっては、違反ワードをただ引用しているだけなどの場合もあるため、建設的な議論を促すためにはどのような意図でその言葉が使用されているか確認する必要があるでしょう。

このように複数の手法を組み合わせることで、コンテンツモデレーションの精度を高めると同時に、モデレーターの負荷の軽減にも繋がります。

コンテンツモデレーション(投稿監視)における課題

人間がコンテンツモデレーターを務める場合、悪意あるコンテンツなど閲覧において精神的に負荷がある情報を日常的に確認しなければなりません。

そのため、通常業務よりも多くのストレスがかかってしまいます。結果的にコンテンツモデレーターとして働く従業員のメンタルヘルスに影響がある場合も考えられます。

コンテンツモデレーターのメンタルヘルスを守りながら効率よく悪意のあるコンテンツを取り締まるには、既に開設した通りツールやAIによる自動化との併用が有効です。

また、コンテンツモデレーション(投稿監視)の難しさの一つは、何を不適切なコンテンツとして定義するかという点です。不適切なコンテンツの定義を広くしてしまうとコンテンツの多様性が失われてしまい、プラットフォーム自体の魅力がなくなってしまう場合も考えられます。

自社に人材がいない場合には、コンテンツモデレーション(投稿監視)サービスを提供する外部企業に委託するのも一つの手です。

コンテンツモデレーションサービスを提供する企業には、モデレーターのメンタルヘルスを担保するカウンセリングなどの支援があることも少なくありません。

コンテンツモデレーション(投稿監視)の導入と運用

コンテンツモデレーション(投稿監視)の導入と運用手順について見ていきましょう。

①ガイドラインとポリシーの策定

コンテンツモデレーション(投稿監視)を始めるには、まず自社でどのようにモデレーションを行うのかガイドラインやポリシーを策定する必要があります。

自社において不適切なコンテンツをどのように定義するか、ユーザーへの対応方針の作成などがこれに該当します。

ガイドラインやポリシーを策定することにより、実際にコンテンツモデレーション(投稿監視)を行うモデレーターやシステムが、迷いなく判断できるようになります。

例えば、他者の著作権などにおける知的財産権の侵害をどう判断していくかや、どこまでを建設的な批判としてどこからがヘイトスピーチに該当するか、などをガイドラインにて適切に定める必要があります。

参考・出典:メタバース上のコンテンツ等をめぐる新たな法的課題等に関する論点の整理│首相官邸

②法務部門との連携を行う

コンテンツモデレーション(投稿監視)は、ユーザーのプライバシーや表現の自由に関わる重要な取り組みです。

法的な側面を十分に考慮し、適切なモデレーションを行うことが必要とされるため、ガイドラインやポリシー策定にあたっては法務部なども交えながら対策を検討しましょう。

③モデレーターの採用とトレーニング

モデレーションを行うスタッフやモデレーターは、不適切なコンテンツの判断基準を理解しなければなりません。

ガイドラインや経験などをもとにして正確な判断を行うことが、コンテンツモデレーション(投稿監視)においては求められます。

ガイドラインは企業によって定められるため一概にはいえません。そのため、採用後自社のガイドラインに則した業務を行うためのトレーニングは必須です。

④自動化技術の導入

大量のコンテンツをモデレーションする必要がある場合は、自動化ソフトウェアを導入して対応することで効率化できます。

事前に設定した特定のキーワードやパターンなどを検出して、自動的に該当するコンテンツの制限が可能です。

自動化技術の導入により、人による確認が最小限で済むためメンタルヘルスの問題を最小化できます。

⑤モニタリングと改善

ガイドラインなどに基づいてコンテンツモデレーション(投稿監視)を行っていても、結果の定期的なモニタリングと改善は欠かせません。

オンライン上のコンテンツはトレンドの移り変わりも早いため、新しいコンテンツの傾向などをつかむのも重要です。

例えば、ソーシャルメディアの主流はかつてテキストでしたが、現在は数秒から数十秒の短い動画コンテンツが人気で訴求力も高くなっています。

動画は主にタグ付けされ拡散されるため、流行のハッシュタグを理解する必要もあります。

コンテンツを取り巻く状況もモニタリングしながら、ガイドラインやポリシーを改善していきましょう。

まとめ

スマートフォンなどに代表されるデバイスの普及や、SNSの普及によりインターネット上の情報収集機会は増加の一途をたどっています。

不適切で悪意のあるコンテンツを放置すると、犯罪行為に繋がってしまったり、自社ブランドのイメージを棄損したりする可能性もあります。

Metaの事例からも、コンテンツモデレーション(投稿監視)は企業姿勢とブランドイメージ、そしてユーザーを守るために、非常に重要な取り組みだといえるでしょう。

コンテンツモデレーション(投稿監視)の方法と種類には、自動フィルタリング・手動によるチェック・ユーザー相互のコミュニティ監視・手動とAIの組み合わせがあります。

不適切なコンテンツを判断するための線引きが難しいこともあり、AI自動フィルタリングなどでまずおおまかな判別を行い、最終的には人による細かな判断を行うケースも多くなっています。

Adeccoでは、人事関連のお役立ち情報を定期的に更新しております。

メールマガジンにご登録いただくと、労働法制や人事トレンドなどの最新お役立ち情報をチェックいただけます。

最新の人事お役立ち情報を受け取る(無料)